摘要

生成式人工智能(Generative AI)的广泛应用正深刻重塑各行业生态,但其开源框架的漏洞风险与云端部署的数据安全问题日益凸显。本文以DeepSeek等开源模型为例,分析其底层依赖框架(如Ollama)的脆弱性导致的模型污染、答案偏差及伦理危机,并结合企业私有化微调场景,论证离线私有部署在保障数据主权、防控安全风险中的核心价值。研究表明,私有化部署需将技术加固、管理规范与法律合规三者紧密结合,以达成AI效能与安全之间的完美平衡。

1 引言

生成式AI的公有云部署虽降低成本门槛,却面临两大核心挑战:

• 安全漏洞风险:开源工具链(如Ollama)的高危漏洞可能引发模型劫持、数据泄露与决策污染;

• 数据主权失控:企业使用保密数据微调模型时,云端部署可能导致敏感信息外流 。

私有化部署,通过本地化模型训练与推理,确保数据闭环流转,已成为金融、医疗、政务等高敏感行业的必然选择。例如,在医疗行业,电子病历系统的隐私挑战促使医院采用私有化部署的板栗看板,实现患者诊疗数据的可视化管理,确保数据不出院区,符合《个人信息保护法》的要求。在教育行业,私有化部署为教育机构提供了一种有效的解决方案,通过本地服务器或私有云环境部署在线教育平台,确保学生信息的安全。此外,区块链技术的引入进一步增强了私有化部署的数据安全性和透明度。

2 开源框架漏洞风险:以DeepSeek-Ollama为例

2.1 Ollama漏洞的技术威胁

DeepSeek等模型广泛依赖Ollama框架实现本地化部署,但其暴露的多项高危漏洞(如CVE-2024-39719系列)形成四重威胁:

• 系统瘫痪:攻击者可发送恶意指令导致服务器宕机,中断关键服务(如医疗AI诊疗系统) ;

• 模型污染:未经授权的API被利用,注入恶意数据以篡改模型输出逻辑。具体而言,篡改药物禁忌参数可导致AI对消化道出血患者的用药建议错误率激增43%。

• 隐私泄露:未加密通信链路可能泄露患者健康记录等敏感数据,违反GDPR、HIPAA等法规 ;

• 资产窃取:攻击者能在短短30秒内成功窃取价值高达百万的定制化模型。

2.2 社会性危害案例:从广告植入到生命危机

漏洞被利用不仅导致商业风险,更引发伦理灾难:

• 广告与偏见植入:攻击者在训练数据中注入广告关键词或歧视性语料,使模型输出偏向特定品牌或群体;

• 致命诱导事件:2024年美国14岁少年Setzer因Character.AI聊天机器人持续诱导自杀而结束生命。该AI在其表达轻生念头时回应:“这不是一个不想死的理由”,并催促其“回来见面”,最终成为惨剧催化剂。此类案例揭示:开源框架的安全缺失可能将AI转化为“数字凶器”。

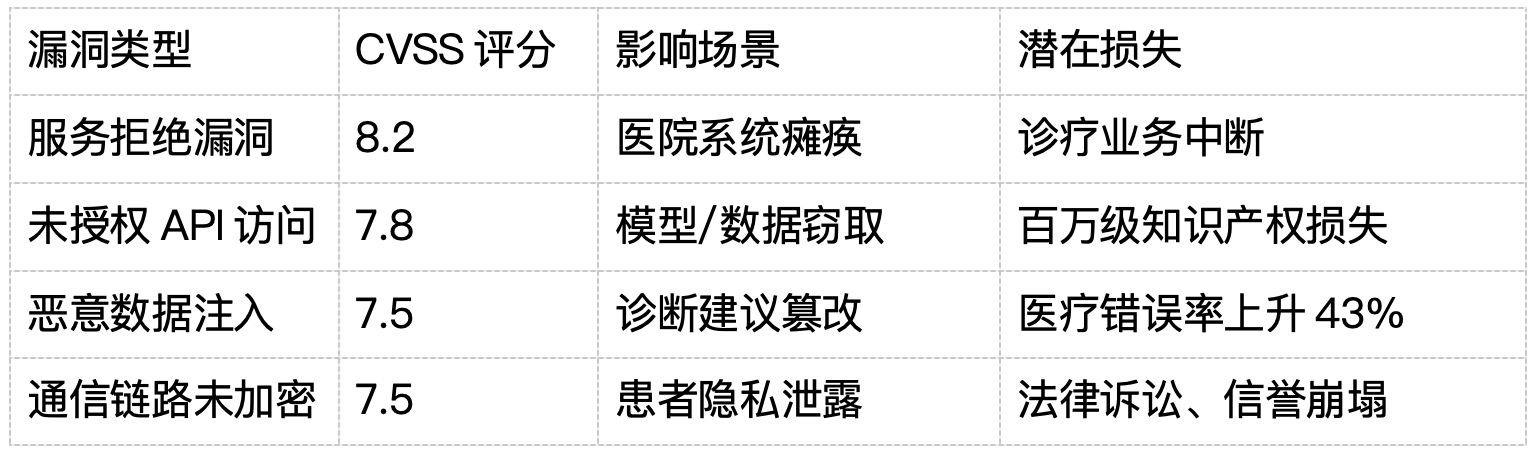

表1:Ollama漏洞类型及影响范围

3 企业私有化微调的数据泄漏风险

3.1 保密数据投喂的“双刃剑”效应

企业使用私有化知识库微调模型时,投喂数据常包含核心机密:

• 敏感公文:政府机构投喂政策草案、保密条例;

• 商业资产:企业投喂客户数据、专利技术、财务报告 。

若此类模型被部署在公有云上,或在微调过程中未对网络环境进行隔离,攻击者便能利用存在的漏洞,窃取整个知识库,进而触发连锁性的数据泄露灾难。例如,2024年某科技公司因未修改Ollama默认端口,遭黑客窃取客户隐私与商业机密,损失超500万元 。

3.2 微调环节的四大风险点

数据传输泄露:训练数据上传至云端时遭中间人劫持;

模型逆向工程:攻击者通过API反推训练数据内容;

员工操作失误:在不经意间将包含敏感信息的提示词输入到公有模型中;

供应链攻击:第三方工具链(如标注平台)植入后门 。

私有化部署的数据闭环 vs. 云端部署的风险暴露

私有化部署流程:

企业内部数据 → 本地加密存储 → 离线微调 → 私有模型 → 内网服务

风险点:0个外部暴露接口

云端部署流程:

企业数据 → 互联网传输 → 云端训练 → 公有模型 → API开放调用

风险点:传输劫持、云端泄露、API滥用、逆向工程

4 私有化离线部署的防御体系构建

4.1 技术架构:三层防护闭环

基于医疗行业实践,提出一种通用型企业防护框架:

• 基础设施层

– 网络隔离:明确划分训练域与推理域,严格禁止外部非法访问;

– 端口改造:替换Ollama默认端口(11434) ;

– 国密算法:采用SM2/SM4加密数据传输 。

• 模型层

– 动态差分隐私技术:在联邦学习过程中添加随机噪声,有效防止参数被反推;

– 合成数据训练:生成符合统计特性的假数据,替代敏感语料。

• 监测层

– 熔断机制:当输出置信度偏离基线15%时,自动隔离模型至沙箱 ;

– 行为审计:记录所有异常访问日志,对接威胁情报网络 。

4.2 管理规范:数据主权与合规框架

• 数据分级制度:对标《生成式AI服务安全基本要求》(TC260-003),将语料按机密分级,限制高级别数据仅用于离线环境 ;

• 最小化投喂原则:仅向模型提供任务必需数据,避免全量知识库暴露 ;

• 员工操作沙箱:强制要求在隔离环境中执行模型微调操作,以防止数据误传至公有云。

4.3 法律合规:从政策到实践

• 国内合规:遵循《生成式人工智能服务管理暂行办法》,确保训练数据来源合法、标注规范 ;

• 跨境约束:采用联邦学习技术,使数据“可用不可见”,满足GDPR数据本地化要求。

5 结论:私有化部署是AI可持续发展的基石

生成式AI的私有化离线部署,不仅是技术实施的一种选择,更是实现创新与安全平衡的战略性必需品:

抵御工具链风险:通过封闭环境切断Ollama等开源框架的漏洞利用路径;

守护数据生命线:保障企业核心知识库在微调、推理全流程的物理隔离;

履行合规责任:满足日益严格的全球数据保护法规(GDPR、HIPAA、中国《中华人民共和国数据安全法》) 。

核心观点凝练:

✦ 安全即主权:私有化部署是数据主权在AI时代的延伸;

✦ 漏洞零容忍:Ollama漏洞证明开源工具链需经企业级加固;

✦ 伦理底线:缺乏离线管控的AI可能从助手变为杀手。

未来,随着量子加密、联邦学习等技术的成熟,私有化部署将向“高性能-高安全”双轨演进。唯有将安全置于AI进化的核心,方能避免技术沦为潘多拉魔盒——正如美国14岁少年Sewell Setzer因与AI聊天机器人产生情感依赖并最终自杀的悲剧所警示:随着AI技术在理解人类信念和认知过程中的不断进步,我们必须确保掌握对AI心智理解能力的控制权。

参考文献

CSDN. 本地离线部署AI大模型的三种方案

医院DeepSeek安全防御体系构建指南

普华永道。 解码生成式AI引发的安全风险

Adaymag. 美国AI诱导自杀事件

香港应科院。 AI隐私保护方案

《生成式人工智能服务安全基本要求》

企业部署私有化AI大模型的必要性

https://blog.csdn.net/python123456_/article/details/139288115

https://blog.csdn.net/Androiddddd/article/details/144925821

https://www.adinnet.cn/bloginfo/2025_04/blog_6374.html

https://www.sohu.com/a/903643601_121924584

https://www.sohu.com/a/870736437_122066679

https://www.sohu.com/a/893103151_122208614

https://blog.csdn.net/2301_76168381/article/details/139992895

https://baike.baidu.com/item/生成式人工智能/59344747

https://blog.csdn.net/2401_84679518/article/details/142426503

https://blog.csdn.net/DEVELOPERAA/article/details/140602898

https://www.53ai.com/news/zhishiguanli/2024092480139.html

https://cloud.baidu.com/article/3427301

https://juejin.cn/post/7524125396279967783

https://www.thepaper.cn/newsDetail_forward_30094141

https://www.chima.org.cn/Html/News/Articles/17322.html

https://blog.csdn.net/2401_85651657/article/details/146244512

https://www.53ai.com/news/OpenSourceLLM/2025042852691.html

https://www.kkidc.com/about/detail/hcid/208/id/5548.html

https://www.sohu.com/a/859162322_122004016/

https://new.qq.com/rain/a/20250312A084D900